2 软间隔与正则化

2.1 软间隔

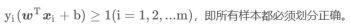

硬间隔(hard margin)要求所有样本均满足约束:

软间隔(soft margin)允许某些样本不满足约束,即允许支持向量机在一些样本上出错。

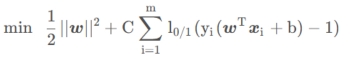

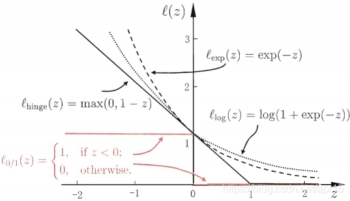

在最大化间隔同时,不满足约束的样本应尽可能少,优化目标如下:

其中C>0是一个常数,为惩罚参数。当C为无穷大时,会迫使所有样本满足约束。

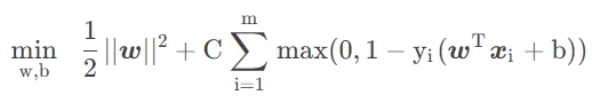

采用hinger loss,则

引入松弛变量(slack variables)

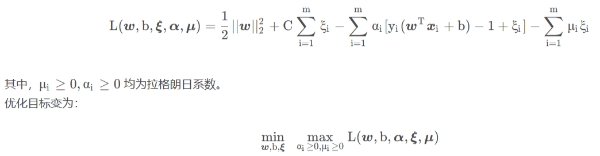

这仍是一个二次规划问题,可通过拉格朗日乘子法得到其拉格朗日函数:

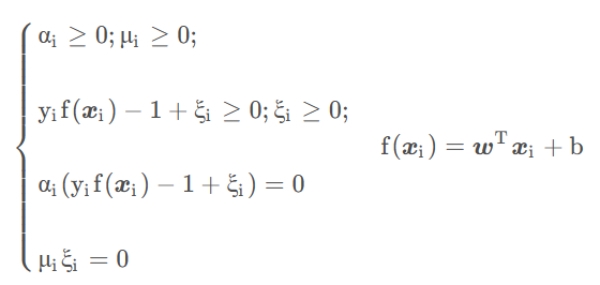

该优化目标满足KTT条件,即

其对偶问题为:

先求优化函数对于w,b,ξ的极小值, 接着再求拉格朗日乘子α,μ的极大值。

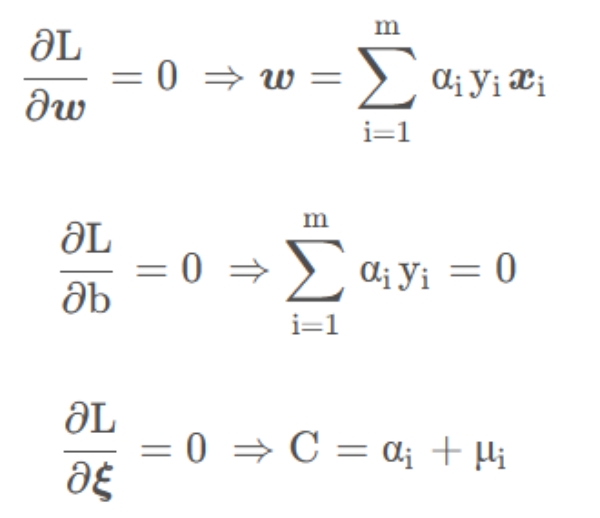

L(w,b,α,ξ,μ)关于w,b,ξ的极小值可以通过分别求偏导得到:

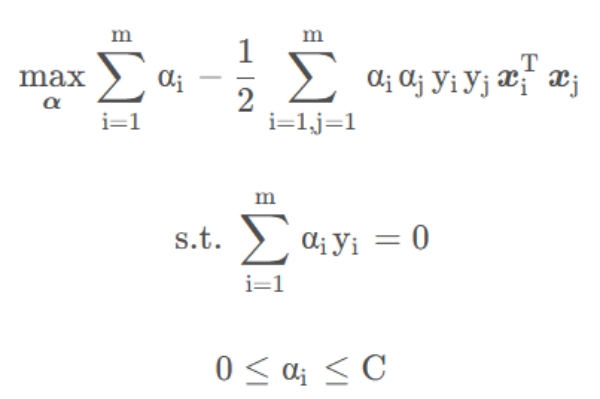

将其代入L(w,b,α,ξ,μ),优化目标最终如下:

此时,优化函数仅有α做为参数,可采用SMO(Sequential Minimal Optimization)求解。

2.2 正则化

相当于使用对率回归模型(实际上,支持向量机与对率回归的优化目标相近,通常性能也相当。对率回归的优势在于输出具有自然的概率意义,即在给出预测标记的同时也给出了概率,而支持向量机不具有概率意义)。

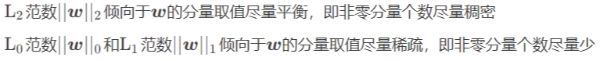

这些模型的性质与所用的替代函数直接相关,且具有共性:

第一项描述划分超平面的“间隔”大小

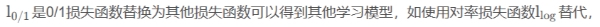

更一般的形式如下:

Ω(f):结构风险(structural risk),描述模型f的某些性质,为引入领域知识和用户意图提供了途径,有助于削减假设空间,降低过拟合风险。

C:正则化常数,对上述两者进行折中

正则化可理解为一种“罚函数法”,即对不希望的结果施以惩罚,使优化过程趋于希望目标。从贝叶斯估计的角度来看,正则化项被认为提供了模型的先验概率。

在正则化问题中,C称为正则化常数,Ω(f)称为正则化项,

SVM(二):软间隔与正则化

为你推荐

-

自动驾驶图像点云融合深度学习综述论文笔记Deep Learning for Image and Point Cloud Fusion in Autonomous Driving: A Review

阅读数 2590 评论数 0 -

实例介绍TensorFlow的输入流水线

阅读数 2602 评论数 0 -

使用NNI对BERT模型进行粗剪枝、蒸馏与微调

阅读数 1922 评论数 0 -

机器学习基础

阅读数 3358 评论数 0 -

OpenAI官方提示词课(四)如何进行文字的情感分析

阅读数 1449 评论数 0 -

语义实例分割1-01:snake(实时实例分割))-资源下载(前奏准备)

阅读数 1396 评论数 0

评论(0)

您还未登录,请登录后发表或查看评论