5. SDEdit: Guided Image Synthesis and Editing With Stochastic Differential Equations

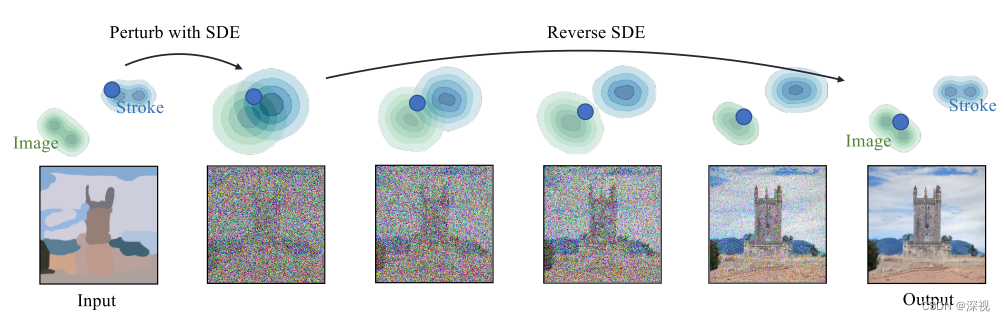

该文提出一种基于SDE扩散模型的引导图像生成和编辑方法。通过使用者在原图上给出一些引导,比如在图像上涂鸦或者增加一个图块,甚至可以不给定原图,直接纯手工绘制一个涂鸦作为输入,模型就能够根据输入的带有引导信息的图像生成对应的结果,如下图所示。

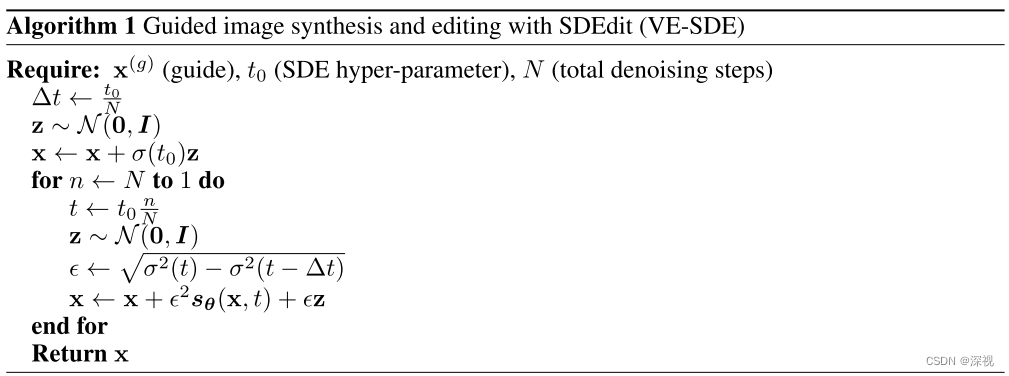

生成的过程基本延续了SDE的方法,作者在正文中以VE-SDE为例介绍了扩散和采样的过程,在附录中给出了VP-SDE的介绍,二者本质上是一致的。首先,SDEdit对输入的图像x^{(g)}按照扩散的过程逐步添加噪声,得到干扰后的图像x^{(g)}(t_0),然后再对x^{(g)}(t_0)按照逆SDE的过程进行逐步的去噪采样,最终得到生成结果x(0)。过程描述和算法流程如下图所示

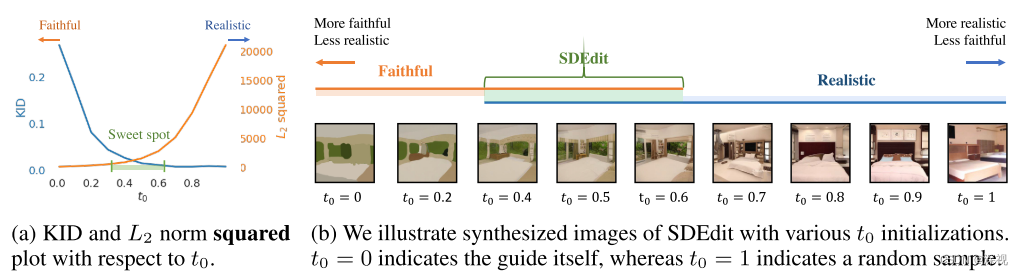

在SDE中,我们通常取[0,1]作为连续变量t的取值范围,扩散过程中t:0\rightarrow1,生成过程中:过程中t:1\rightarrow0。但在本文中,作者发现扩散过程的最终时间和生成过程的开始时间t_0不一定要取1,可以取[0,1]中间的任意一个值。并且随着t_0增大,生成结果更加真实,但与输入引导的一致性变得更差;反之,随着t_0减小,生成结果更加接近输入的引导图像,但结果不够真实,如下图所示

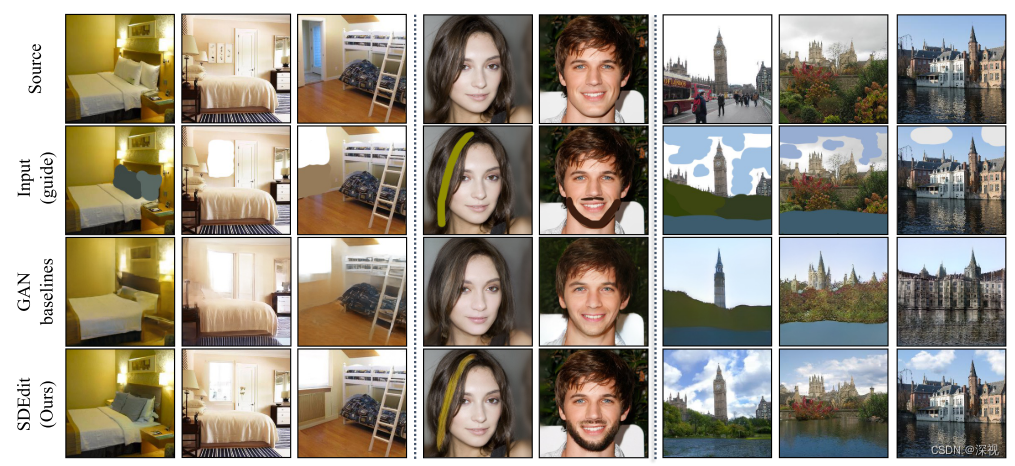

经过实验,作者找到一个能够兼顾一致性和真实性的取值区间,t_0\in [0.3,0.6]。作者将SDEdit与其他基于GAN的图像生成和编辑算法进行了对比,结果表明SDEdit在多个数据集和多个指标上都超过了现有的最优的方法。

评论(0)

您还未登录,请登录后发表或查看评论